VTuber3D撮影風景の魅力と技術

「Vtuberの3d撮影風景ってどうなってるの?」「VTuberの3Dモデルはどうやって動いているの?」――そんな疑問を持ったことはありませんか。最近では、VTuberが美しいバーチャル空間だけでなく、現実風景 合わせる形で活動する姿や、にじさんじ ライブ 舞台裏のような大規模な3Dライブを見る機会も増えました。

この記事では、VTuberの3Dってどうやって撮ってる?という疑問にお答えします。モーションキャプチャー(モーキャプ スタジオでの本格的なものから、自宅で行う方法まで)やトラッキングの基本的な仕組み、そして背景 合成 グリーンバック技術の活用法などを分かりやすく解説。さらに、3Dライブの仕組み、撮影方法や、有観客ライブの仕組みの裏側、トラッキングスーツ 機材といった最新技術にも触れながら、VTuberたちがどのように魅力的な3Dコンテンツを生み出しているのか、その秘密に迫ります。

- VTuberの3Dモデルが動く基本的な仕組み(モーションキャプチャー、トラッキング)

- 3D映像の背景合成技術(グリーンバック、AR、ボリュメトリックビデオ)

- 3Dライブの制作方法やスタジオと自宅での3D撮影の違い

- 3D撮影に使われる最新機材と今後の技術的な可能性

- VTuber3D撮影風景とは?

- VTuberの3Dモデルはどう動くの?

- トラッキングとモーションキャプチャー

- 背景合成グリーンバック技術の活用

- 現実風景と合わせる撮影方法とは?

VTuber3D撮影風景とは?

VTuberの3D撮影風景というのは、VTuberさんが3Dの体(アバター)を使って、まるで現実の世界にいるかのように、あるいはバーチャル空間の美しい景色の中で活動している様子を映し出すことです。 ライブ配信やミュージックビデオ、時には旅行風の動画などで、VTuberさんが様々な背景と一緒に映っているのを見たことがある人もいるかもしれませんね。

これは、単にVTuberさんの3Dモデルと背景画像を合成するだけでなく、カメラが動いたり、VTuberさんと背景が自然に馴染んでいたり、より没入感のある映像を作るための様々な工夫が凝らされています。 例えば、現実のバンドメンバーとVTuberさんが同じステージに立ってライブをする、といった特別なコラボレーションも、この3D撮影技術によって実現されています。 このように、VTuberさんがよりリアルに、あるいはより魅力的な世界観で活動する様子を、様々な技術を使って表現するのが3D撮影風景と言えるでしょう。

3D撮影って、普通の動画と何が違うの?

3D撮影はVTuberの立体モデルをリアルに動かして、現実の風景やバーチャル背景と自然に組み合わせるの!

VTuberの3Dモデルはどう動くの?

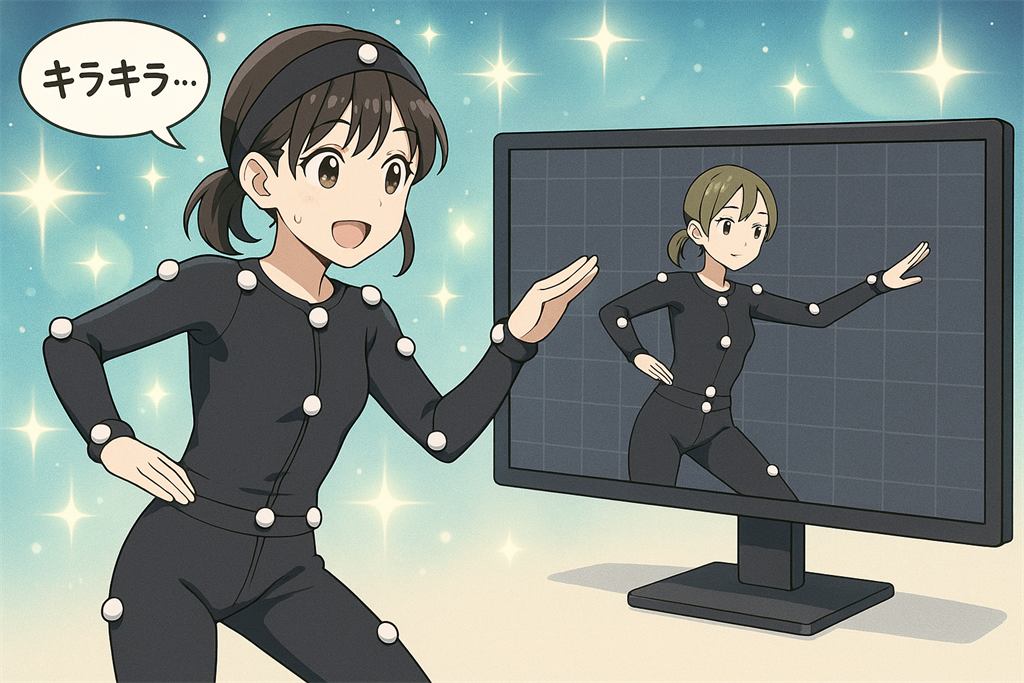

VTuberさんの3Dモデルが、まるで生きているかのように滑らかに動くのは不思議ですよね。あれは、「モーションキャプチャー」という技術が使われているからです。 簡単に言うと、実際の人間の動きをセンサーなどで読み取って、それを3Dモデルに反映させる仕組みです。

まず、演者さん(VTuberの中の人)が、体にたくさんのマーカー(目印)が付いた特殊なスーツを着たり、センサーが付いた機材を装着したりします。 そして、スタジオの中で動くと、その動きを周りに設置された複数のカメラやセンサーが捉えます。 例えば、腕を上げたり、ジャンプしたりすると、その関節の動きや位置の情報がコンピュータに送られます。

コンピュータは、送られてきた情報をもとに、「このVTuberの3Dモデルの、この部分を、このように動かす」という計算をリアルタイムで行い、3Dモデルに同じ動きをさせます。 顔の表情も同じように、カメラで顔のパーツの動きを読み取ったり、iPhoneのFaceIDのような機能を使ったりして、3Dモデルの表情に反映させています。 このようにして、VTuberさんの3Dモデルは、まるで本人がそこにいるかのように自然に動くことができるのです。

あの動きってアニメみたいだけど、どうやってやってるの?

中の人が動くと、センサーがその動きを読み取って、3Dモデルにリアルタイムで反映してるんだよ!

トラッキングとモーションキャプチャー

「トラッキング」と「モーションキャプチャー」は、VTuberさんの3Dモデルを動かす上でとても大切な技術ですが、少し意味合いが異なります。

「トラッキング」というのは、物や人の位置、動き、向きなどを「追跡する」技術全般を指します。 VTuberの文脈でよく使われるのは、顔の表情を追跡する「フェイストラッキング」や、VRゴーグルやコントローラーの位置を追跡する「ヘッドトラッキング」「ハンドトラッキング」などです。これらは、ウェブカメラや専用のセンサーを使って、比較的手軽に行うことができます。

一方、「モーションキャプチャー(モーキャプ)」は、トラッキング技術を応用して、全身の複雑な動きをデータとして記録し、それを3Dキャラクターなどに反映させる、より専門的な技術です。 前述のように、体にマーカーを付けたスーツを着て、専用のスタジオで複数のカメラを使って全身の動きを高精度に捉えるのが一般的です。 指の細かい動きまで再現できるような高度なシステムもあります。

つまり、トラッキングは「追跡する」という広い意味の技術で、モーションキャプチャーはトラッキングを使って全身の動きを捉え、活用する具体的な手法の一つ、と考えると分かりやすいかもしれません。

トラッキングとモーキャプって、どう違うの?

トラッキングは動きを追う仕組みで、モーキャプは全身の動きを高精度に記録する技術なんだ!

背景合成グリーンバック技術の活用

VTuberさんが、まるで別の場所にいるかのように見える映像を作る際によく使われるのが「グリーンバック」という技術です。 これは、背景を緑色(時には青色)の布や壁にして撮影し、後からその緑色の部分だけを透明にして、別の背景画像や映像と合成する仕組みです。

なぜ緑色かというと、人間の肌の色と補色(反対の色)の関係にあり、人物と背景を区別しやすいためです。 ニュースのお天気コーナーで、キャスターさんが大きな地図の前に立っているように見えるのも、このグリーンバック技術が使われています。

VTuberさんの3D配信でも、演者さんがグリーンバックのスタジオでモーションキャプチャーを行い、その動きを3Dアバターに反映させます。そして、3Dアバターの映像から緑色の背景を消し、バーチャル空間の背景や、現実の風景映像と組み合わせることで、VTuberさんが様々な世界で活動しているように見せることができるのです。キヤノンのボリュメトリックビデオ技術のように、現実の人物を3Dデータ化してバーチャル空間に配置する際にも、このグリーンバックの考え方が応用されていることがあります。

背景って本当にそこにあるの?

違うよ!緑の布の前で撮影して、あとから背景を合成してるの。ニュースの天気予報と同じ原理!

現実風景と合わせる撮影方法とは?

VTuberさんがまるで現実の風景の中に立っているかのように見える映像や画像は、いくつかの方法で撮影されています。 一番シンプルなのは、グリーンバックで撮影したVTuberさんの映像を、現実の風景写真や動画と後から編集で合成する方法です。 これは比較的取り組みやすい方法と言えるでしょう。

もっと進んだ方法としては、「AR(拡張現実)」技術を使うものがあります。 これは、スマートフォンのカメラなどを通して現実の風景を見たときに、そこにVTuberさんの3Dモデルを重ねて表示させる技術です。ソニーの「mocopi」というモバイルモーションキャプチャーシステムにも、このAR背景モードが搭載されており、VTuberさんが渋谷の街中に出現したかのような映像を撮影できます。

さらに高度な方法としては、キヤノンの「ボリュメトリックビデオ」技術のようなものがあります。 これは、たくさんのカメラで現実の人物や場所を撮影し、それを3Dデータとして再構成する技術です。この3Dデータ化された現実の風景の中に、モーションキャプチャーで動くVTuberさんの3Dモデルを配置することで、非常にリアルな共演映像を作り出すことができます。「バズリズム LIVE V 2023」でのフジファブリックと星街すいせいさんのコラボライブは、この技術が使われた良い例です。 これらの技術によって、VTuberさんはバーチャルとリアルの垣根を越えて、様々な風景の中で活動できるようになっています。

VTuberが現実にいるみたいに見えるのってどうやってるの?

ARや編集で現実の風景に3Dモデルを重ねてるの。技術の力で本当に一緒にいるみたいに見えるんだよ!

VTuber3D撮影風景の最前線

- にじさんじライブ舞台裏の技術

- 3Dライブの仕組みと撮影方法

- モーキャプスタジオと自宅3Dの違い

- 有観客ライブの仕組みと課題

- トラッキングスーツなど最新機材

- 3D撮影風景の未来と可能性

にじさんじライブ舞台裏の技術

にじさんじのような大手VTuber事務所が行う大規模な3Dライブイベントでは、その裏側で様々な高度な技術が使われています。 例えば、にじさんじは自社で大規模なモーションキャプチャスタジオを保有しており、日々その設備を拡充しています。新スタジオでは、複数の3Dスタジオや2Dスタジオ、高品質なレコーディング/編集スタジオを備え、より複雑で大規模な企画に対応できるようになっています。

ライブでは、複数のVTuberさんが同時にステージに立ち、歌ったり踊ったりしますよね。これを実現するためには、それぞれの演者さんの動きを正確にモーションキャプチャーし、遅延なく3Dアバターに反映させる必要があります。大人数でのキャプチャは計算処理も複雑になるため、高性能なコンピューターや並列処理システムが用いられます。

また、指先の細かい動きまで表現するために、多くのマーカーを使ったトラッキングが行われたり、AR(拡張現実)技術やグリーンバックを活用して、現実のステージセットとバーチャルな演出を融合させたりすることもあります。 こういった技術的な挑戦の積み重ねが、ファンを魅了する「魔法のような」ライブ体験を生み出しているのです。

ライブって中の人が何してるの?

広いスタジオで動いてて、その動きが全部3Dアバターに反映されるの。まるで魔法みたいだよね!

3Dライブの仕組みと撮影方法

VTuberさんの3Dライブは、一見するとテレビの音楽番組や実際のコンサートのように見えますが、その制作の仕組みは少し異なります。 まず、VTuberさんの動きは、モーションキャプチャースタジオで演者さんが実際に歌ったり踊ったりした動きをデータとして取り込みます。この時、専用のトラッキングスーツやマーカーが使われます。

取り込まれた動きのデータは、VTuberさんの3Dモデルに適用され、バーチャル空間内のステージでパフォーマンスしているかのようにレンダリング(映像化)されます。 撮影方法としては、バーチャル空間内に仮想のカメラを複数設置し、それらを切り替えたり動かしたりすることで、様々なアングルからの映像を作り出します。これはテレビ番組のスイッチングと似ていますね。

「バズリズム LIVE V 2023」の事例では、現実のアーティストはキヤノンのボリュメトリックスタジオで3Dデータ化され、VTuberはバルス株式会社のモーションキャプチャースタジオで動きを撮影。これらのデータをUnityというゲームエンジン上で統合し、最終的なライブ映像として配信されました。 このように、複数の技術を組み合わせて、バーチャルとリアルが融合したライブが作られています。

カメラって本物じゃないの?

ううん、バーチャル空間に仮想カメラを置いてるんだよ。アングルも自由に変えられて便利なんだ!

モーキャプスタジオと自宅3Dの違い

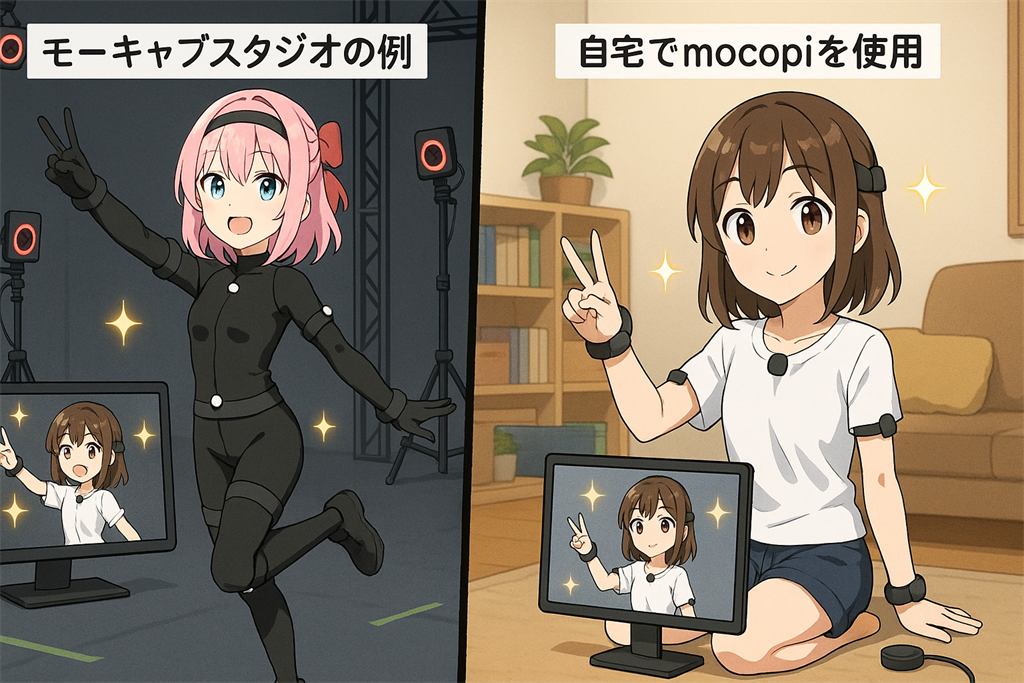

VTuberさんが3Dで活動する方法には、大きく分けて「モーションキャプチャースタジオを利用する方法」と「自宅で機材を揃えて行う方法」があります。この二つには、それぞれメリットとデメリットがあります。

モーキャプスタジオの最大のメリットは、非常に高精度な動きのキャプチャができることです。専用の広いスペースに多数の高性能カメラやセンサーが設置されており、演者さんの全身の動きはもちろん、指先の細かい動きまで正確に捉えることができます。また、照明やカメラワークなどを専門のスタッフに任せられるため、演者さんはパフォーマンスに集中できます。デメリットとしては、利用料金がかかることや、スタジオの予約が必要なことなどが挙げられます。

一方、自宅3Dのメリットは、比較的低コストで始められ、時間の制約なく気軽に3D配信や動画撮影ができることです。ソニーの「mocopi」のようなモバイルモーションキャプチャーシステムや、VIVEのようなVR機器を使えば、自宅でもある程度のフルトラッキング(全身の動きの追跡)が可能です。デメリットとしては、スタジオほどの精度は期待しにくいこと、機材のセッティングやトラブルシューティングを自分で行う必要があること、広いスペースが必要な場合があることなどです。活動の規模や目的に合わせて、どちらの方法が良いかを選ぶことになります。

自宅とスタジオって何が違うの?

スタジオは超高精度だけど高コスト。自宅は機材を使えば手軽にできるけど、精度はちょっと落ちるの。

有観客ライブの仕組みと課題

VTuberさんのライブイベントには、オンライン配信だけでなく、実際に観客を入れて行われる「有観客ライブ」もあります。 これは、ファンにとってVTuberさんをより身近に感じられる貴重な機会ですが、実現するにはいくつかの仕組みと課題があります。

仕組みとしては、多くの場合、大きな会場に設置された巨大なスクリーンにVTuberさんの3Dモデルが等身大で映し出され、リアルタイムでパフォーマンスを行います。演者さんは別の場所にあるモーションキャプチャースタジオで動き、そのデータが会場のスクリーンに送られてアバターを動かします。観客は、スクリーン上のVTuberさんに向かって声援を送ったり、ペンライトを振ったりして、一体感のあるライブを楽しみます。

課題としては、まず技術的な安定性が求められます。モーションキャプチャーのデータ送信や映像表示に遅延やトラブルが発生すると、ライブの進行に大きな影響が出てしまいます。また、会場の規模や演出によっては、非常に高価な機材や多くのスタッフが必要となり、コストも大きな課題です。さらに、オンライン配信とは異なり、会場の音響や照明、観客の誘導など、リアルイベント特有の運営ノウハウも必要になります。

有観客って、どうやってやってるの?

別の場所から動きを送って、会場のスクリーンにリアルタイムで映してるの。技術も運営も大変なの!

トラッキングスーツなど最新機材

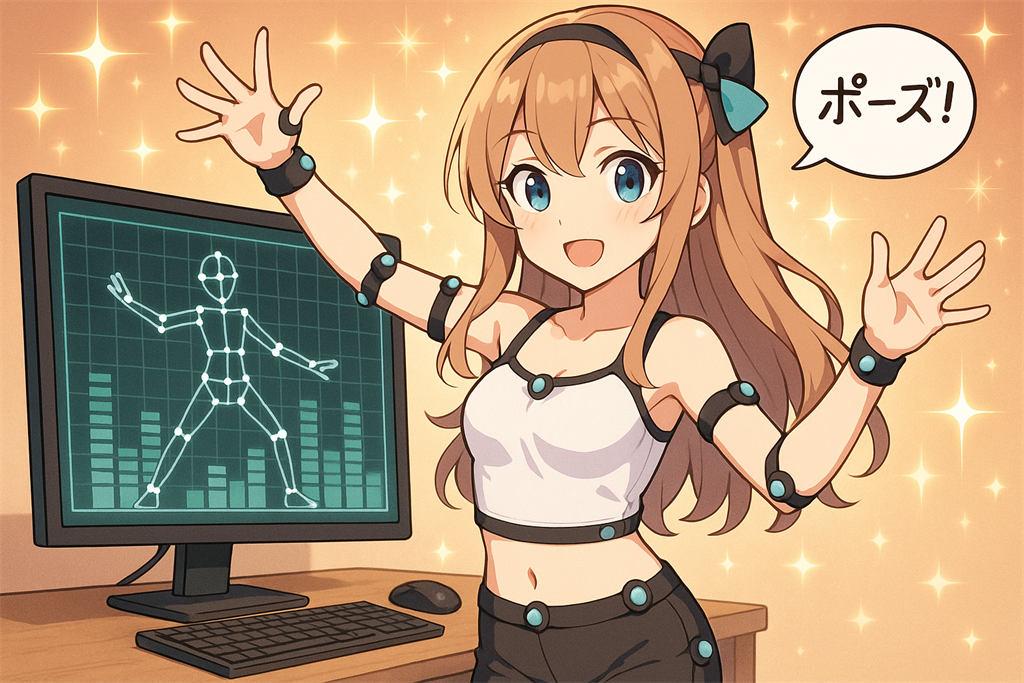

VTuberさんのリアルな動きを実現するためには、トラッキングスーツをはじめとする様々な最新機材が活用されています。 トラッキングスーツは、演者さんが着用する体にフィットした服で、全身の動きを捉えるためのマーカーやセンサーが取り付けられています。 光学式モーションキャプチャーシステムでは、小さな反射マーカーをスーツの関節部分などに多数貼り付け、それを複数の赤外線カメラで撮影して位置情報を取得します。

ソニーの「mocopi」のような新しいシステムでは、体に装着する小型軽量のセンサーだけで全身の動きをトラッキングできます。これにより、専用のスーツを着なくても、より手軽にフルトラッキングが可能になりました。 指の細かい動きを捉えるためには、専用のグローブ型センサー(例:NOITOM Hi5)が使われることもあります。

顔の表情を捉える技術も進化しており、iPhoneのTrueDepthカメラを利用した「パーフェクトシンク」という仕組みを使えば、より生き生きとした豊かな表情を3Dアバターに反映させることができます。 これらの最新機材は、VTuberさんの表現の幅を広げ、より魅力的な3Dコンテンツ制作を可能にしています。

なんでスーツを着るの?

動きを正確にキャプチャするために必要なの。最近はセンサーだけでもできる手軽な機材もあるよ!

3D撮影風景の未来と可能性

VTuberの3D撮影技術は、日々進化しており、その未来には大きな可能性が広がっています。 例えば、キヤノンのボリュメトリックビデオ技術のように、現実の空間や人物をまるごと3Dデータ化する技術がさらに発展すれば、VTuberと現実世界の融合はより自然で没入感のあるものになるでしょう。カメラの解像度向上やデータ処理速度の高速化により、バーチャル空間に描画される人物や風景のディテールはますます細かくなるはずです。

また、ソニーの「mocopi」のような手軽なモーションキャプチャー機材の登場は、個人VTuberさんでも3D活動を始めやすくなるきっかけとなります。これにより、多様な3Dコンテンツが生まれ、VTuber業界全体の活性化に繋がるかもしれません。 AR技術の進化も重要で、VTuberが現実の風景に自然に溶け込み、まるで一緒に旅行しているかのような体験を提供できるようになるでしょう。

将来的には、視聴者がよりインタラクティブに3Dライブに参加できたり、VTuberとバーチャル空間で直接触れ合えたりするような、新しいエンターテイメントの形が生まれるかもしれません。 技術の進歩とともに、VTuberの3D撮影風景は、私たちの想像を超えるような驚きと感動を与えてくれることでしょう。

これからのVTuberってどうなるの?

現実とバーチャルの境界がもっと曖昧になって、直接会えるような体験もできるかもしれないよ!

VTuber3D撮影風景の技術と未来まとめ

- VTuberの3D撮影風景は3Dアバターと背景を組み合わせた映像表現である

- モーションキャプチャーで演者の動きを3Dモデルに反映させる

- トラッキングは動きを追跡する技術、モーキャプは全身の動きを記録する手法である

- グリーンバック技術で撮影し背景を合成することが一般的である

- AR技術やボリュメトリックビデオで現実風景との融合が可能である

- 大手事務所は大規模スタジオと高度な技術でライブ制作を行う

- 3Dライブは演者の動きをデータ化しバーチャル空間で映像化する

- モーキャプスタジオは高精度だが費用と予約が必要である

- 自宅3Dは手軽だがスタジオほどの精度は期待しにくい

- 有観客ライブはスクリーン投影で行われ技術的安定性とコストが課題である

- トラッキングスーツやmocopi、表情認識技術など最新機材が活用される

- 現実とバーチャルの融合はさらに自然で没入感のあるものへ進化する

- 個人でも3D活動がしやすくなりコンテンツの多様化が期待される

- AR技術の進化でよりリアルな体験が可能になる

- 将来的には視聴者参加型の新しいエンタメ形態も考えられる